| (38 intermediate revisions by 7 users not shown) | |||

| Line 1: | Line 1: | ||

Dokumentation der im Kurs [[GMU:Audio%2BVideo| Audio + Video]] entstandenen Projekte: | Dokumentation der im Kurs [[GMU:Audio%2BVideo| Audio + Video]] entstandenen Projekte: | ||

==[[Anja Erdmann]]: | ==[[Anja Erdmann]]: [[/Schatten→Klang|Schatten→Klang]]== | ||

[[Image:Still-av_01.jpg|thumb|right|250px|Schatten]] | |||

Aus Licht und Schatten, bzw. ihren Bewegungen sollen Klänge generiert werden. In diesem Fall auf Grundlage des Videos. | |||

[[/Schatten→Klang|Projektdokumentation]] | |||

<br clear="all" /> | |||

< | |||

== [[Cédric Richard]]: [[/MusicPainter|MusicPainter]] == | == [[Cédric Richard]]: [[/MusicPainter|MusicPainter]] == | ||

| Line 41: | Line 23: | ||

<br clear="all" /> | <br clear="all" /> | ||

==[[Florian Erdmenger]]: Link to the Past== | ==[[Florian Erdmenger]]: [[/Link to the Past|Link to the Past]]== | ||

[[Image:A+V F.E. (2).png|thumb|right|250px|Link to the Past]] | |||

Eine interactive Reise in die Vergangenheit. | |||

[[/Link to the Past|Projektdokumentation]] | |||

<br clear="all" /> | |||

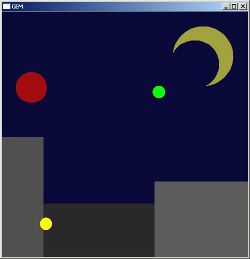

==[[Johann Niegl]]: [[/PDGame|PDGame]]== | ==[[Johann Niegl]]: [[/PDGame|PDGame]]== | ||

[[Image:PDgame2.jpg|thumb|right|250px|PdGame]] | |||

Das PDGame ist ein Projekt, das auf spielerische Weise unterschiedliche Reize miteinander verknüpft. Es handelt sich dabei um ein interaktives Programm das auf auditiven Input visuell und auditiv reagiert. | Das PDGame ist ein Projekt, das auf spielerische Weise unterschiedliche Reize miteinander verknüpft. Es handelt sich dabei um ein interaktives Programm das auf auditiven Input visuell und auditiv reagiert. | ||

| Line 52: | Line 38: | ||

<br clear="all" /> | <br clear="all" /> | ||

==[[Laura Jozefini]]== | ==[[Laura Jozefini]]: [[/Partikelmaker|Partikelmaker]]== | ||

[[Image:Av4.JPG|thumb|right|250px|Partikelmaker]] | |||

Ein kleines Programm, das auf visuellen Input reagiert und diesen in einen abstrakten Bewegungsmelder umwandelt. | |||

[[/Partikelmaker|Projektdokumentation]] | |||

<br clear="all" /> | |||

==[[Mathieu Rathelot]]: Title of the work== | |||

[[Image:WFS-BAUHAUS-UNIVERSITY.jpg|thumb|right|250px|Wavefield-Synthesis]] | |||

This semester, I was interested by working on the sound for a 3D TV project with a wave field synthesis system. But after many test, I realized that it would be to difficult for me to learn how work the WFS system and the 3D system in the same time in only six months. | |||

[[ | |||

This semester, I was interested by working on the sound for a 3D TV project with a wave field synthesis system. But after many test, I realized that it would be to difficult for me to learn | |||

how work the WFS system and the 3D system in the same time in only six months. | |||

So I decided to make a radio drama with the WFS system. | So I decided to make a radio drama with the WFS system. | ||

This radio drama length is about 7 minutes. The story take place in a space | This radio drama length is about 7 minutes. The story take place in a space shuttle. I used pure data to do the spatialization of my sound. On my patch I had three slider for the three axis X,Y and Z wich I can change the position of a sound. I made an automation to change the position of the character during the story. | ||

This is a version of my radio drama without mix. To listen my work you need a WFS system : | This is a version of my radio drama without mix. To listen my work you need a WFS system : | ||

| Line 102: | Line 67: | ||

* [http://www.fairaudio.de/hifi-lexikon-begriffe/stehende-welle-raummoden.html Stehende Welle — Hifi-Lexikon] | * [http://www.fairaudio.de/hifi-lexikon-begriffe/stehende-welle-raummoden.html Stehende Welle — Hifi-Lexikon] | ||

===Bang-Server=== | ===Bang-Server=== | ||

Etwas mehr technisches. Der Bang Server soll eine Möglichkeit sein | Etwas mehr technisches. Der Bang Server soll eine Möglichkeit sein Pure Data bangs mit Timestamp und optionalen Datenpaket dezentral zu verteilen. So kann eine Pure Data Instanz ein Bang und Datenpaket an den Server senden, welcher diese dann an alle andern verbunden Client verteilt. Neben der Echtzeit Komponente soll es noch ein API geben mit dem man die letzten n Bangs erhalten kann. | ||

==[[Meredith Barnes]]: [[/Stop yelling at me|Stop yelling at me]]== | |||

[[Image:stop_yelling.jpg|thumb|right|250px|Screen shot.]] | |||

a work-in-progress interactive animation video. | |||

[[/Stop yelling at me|Project documentation]] | |||

<br clear="all" /> | |||

==[[User:WSebastian|Sebastian Wolf]]: Applaus== | ==[[User:WSebastian|Sebastian Wolf]]: [[/Applaus|Applaus]]== | ||

Ziel soll ein patch sein, der aus '''einem''' in-die-Hände-Klatschen '''etliche''' macht, aus dem Applaus einer einzelnen Person den einer Menschenmasse. | Ziel soll ein patch sein, der aus '''einem''' in-die-Hände-Klatschen '''etliche''' macht, aus dem Applaus einer einzelnen Person den einer Menschenmasse. | ||

''damit man sich selbst applaudieren kann ;)'' | ''damit man sich selbst applaudieren kann ;)'' | ||

Vor allem auf technischer Ebene ist das eine Herausforderung. Gerade aufgrund der relativ komplexen Struktur des patches und der Verarbeitung des Inputs. In erster Linie wird das also ein Weg sein, tiefer in | Vor allem auf technischer Ebene ist das eine Herausforderung. Gerade aufgrund der relativ komplexen Struktur des patches und der Verarbeitung des Inputs. In erster Linie wird das also ein Weg sein, tiefer in Pure Data einzutauchen. | ||

Das Ganze geschieht im Wechselspiel zwischen Benutzer und Computer. So reagiert der Rechner auf jeden Beifall den man IHM gibt mit einem größereren und stärkeren Applaus seinerseits. Nun ist der Mensch wieder an der Reihe - die Maschine fordern, ihr etwas zum imitieren geben. Natürlich beschränkt sich das nicht nur auf schnödes Klatschen, auch andere Geräusche werden vom Programm aufgenommen, vervielfacht und verfremdet. Im Laufe der Zeit entstehen auf diese Weise interessante Klänge und abstrakte Geräuschkulissen. | Das Ganze geschieht im Wechselspiel zwischen Benutzer und Computer. So reagiert der Rechner auf jeden Beifall den man IHM gibt mit einem größereren und stärkeren Applaus seinerseits. Nun ist der Mensch wieder an der Reihe - die Maschine fordern, ihr etwas zum imitieren geben. Natürlich beschränkt sich das nicht nur auf schnödes Klatschen, auch andere Geräusche werden vom Programm aufgenommen, vervielfacht und verfremdet. Im Laufe der Zeit entstehen auf diese Weise interessante Klänge und abstrakte Geräuschkulissen. | ||

Latest revision as of 13:44, 26 May 2011

Dokumentation der im Kurs Audio + Video entstandenen Projekte:

Anja Erdmann: Schatten→Klang

Aus Licht und Schatten, bzw. ihren Bewegungen sollen Klänge generiert werden. In diesem Fall auf Grundlage des Videos.

Cédric Richard: MusicPainter

A player patch, using multitracked musics to create a numeric animated painting.

Dominique Wollniok: VerkehrsMalerei

Verkehrsstraßen sind die Adern einer Stadt. Besonders im Dunklen zeichnen Autos diese nach. Motor-Geräusche überlagern sich und man bekommt den Eindruck von einem rauschenden Meer. Mit meinem Projekt werden die Adern sichtbar und ergeben schließlich ein Netz von Lichtern. Man kann dabei zusehen, wie sich Lichtbahnen überkreuzen.

Florian Erdmenger: Link to the Past

Eine interactive Reise in die Vergangenheit.

Johann Niegl: PDGame

Das PDGame ist ein Projekt, das auf spielerische Weise unterschiedliche Reize miteinander verknüpft. Es handelt sich dabei um ein interaktives Programm das auf auditiven Input visuell und auditiv reagiert.

Laura Jozefini: Partikelmaker

Ein kleines Programm, das auf visuellen Input reagiert und diesen in einen abstrakten Bewegungsmelder umwandelt.

Mathieu Rathelot: Title of the work

This semester, I was interested by working on the sound for a 3D TV project with a wave field synthesis system. But after many test, I realized that it would be to difficult for me to learn how work the WFS system and the 3D system in the same time in only six months. So I decided to make a radio drama with the WFS system.

This radio drama length is about 7 minutes. The story take place in a space shuttle. I used pure data to do the spatialization of my sound. On my patch I had three slider for the three axis X,Y and Z wich I can change the position of a sound. I made an automation to change the position of the character during the story.

This is a version of my radio drama without mix. To listen my work you need a WFS system :

<flashmp3 id="WFS-RADIO-DRAMA-MATHIEU-RATHELOT.mp3">WFS-RADIO-DRAMA-MATHIEU-RATHELOT.mp3</flashmp3>

Matthias Breuer

Raummode

Ziel ist es, ein autonomes Gerät zu konstruieren, dass zwischen zwei parallelen Flächen eine stehende Schallwelle erzeugt. Mittels eines Oszillators, dessen Frequenz stetig inkrementiert wird, findet das Gerät die Frequenz mit der maximalen Amplitude, welche schliesslich die stehende Welle ist.

Bang-Server

Etwas mehr technisches. Der Bang Server soll eine Möglichkeit sein Pure Data bangs mit Timestamp und optionalen Datenpaket dezentral zu verteilen. So kann eine Pure Data Instanz ein Bang und Datenpaket an den Server senden, welcher diese dann an alle andern verbunden Client verteilt. Neben der Echtzeit Komponente soll es noch ein API geben mit dem man die letzten n Bangs erhalten kann.

Meredith Barnes: Stop yelling at me

a work-in-progress interactive animation video.

Sebastian Wolf: Applaus

Ziel soll ein patch sein, der aus einem in-die-Hände-Klatschen etliche macht, aus dem Applaus einer einzelnen Person den einer Menschenmasse. damit man sich selbst applaudieren kann ;)

Vor allem auf technischer Ebene ist das eine Herausforderung. Gerade aufgrund der relativ komplexen Struktur des patches und der Verarbeitung des Inputs. In erster Linie wird das also ein Weg sein, tiefer in Pure Data einzutauchen.

Das Ganze geschieht im Wechselspiel zwischen Benutzer und Computer. So reagiert der Rechner auf jeden Beifall den man IHM gibt mit einem größereren und stärkeren Applaus seinerseits. Nun ist der Mensch wieder an der Reihe - die Maschine fordern, ihr etwas zum imitieren geben. Natürlich beschränkt sich das nicht nur auf schnödes Klatschen, auch andere Geräusche werden vom Programm aufgenommen, vervielfacht und verfremdet. Im Laufe der Zeit entstehen auf diese Weise interessante Klänge und abstrakte Geräuschkulissen. Das regt zum Ausprobieren und Herumspielen an. Auch der visuelle Output weckt Interesse – was passiert da, wie reagiert es auf mich?

Video macht leider Probleme! Dafür hier aber der (nicht ganz so aussagekräftige) Ton dazu.

<flashmp3 id="Applaus-audio.mp3">Applaus-audio.mp3</flashmp3>

- Und die patches zum anschauen: File:Applaus.zip